股票行情软件数据采集如何合法合规?数据源与实时性如何保障?

摘要:

核心概念与数据类型在开始之前,首先要明确你需要采集哪些数据,股票行情数据主要分为以下几类:实时行情数据基本信息:股票代码、名称、当前价、开盘价、最高价、最低价、昨收价、成交量、成交...

摘要:

核心概念与数据类型在开始之前,首先要明确你需要采集哪些数据,股票行情数据主要分为以下几类:实时行情数据基本信息:股票代码、名称、当前价、开盘价、最高价、最低价、昨收价、成交量、成交... 核心概念与数据类型

在开始之前,首先要明确你需要采集哪些数据,股票行情数据主要分为以下几类:

-

实时行情数据

(图片来源网络,侵删)- 基本信息:股票代码、名称、当前价、开盘价、最高价、最低价、昨收价、成交量、成交额、换手率、市盈率、市净率等。

- 逐笔成交:每一笔成交的详细信息,如成交时间、价格、数量。

- 五档行情:买一到买五的挂单价格和数量,卖一到卖五的挂单价格和数量。

-

历史K线数据

- 按不同周期划分,如:1分钟、5分钟、15分钟、30分钟、1小时、日线、周线、月线等。

- 每个周期的数据通常包含:开盘价、最高价、最低价、收盘价、成交量(即OHLCV数据)。

-

财务数据

- 资产负债表、利润表、现金流量表等。

- 总资产、净利润、营业收入、每股收益等。

-

板块/行业数据

板块分类、板块内的成分股、板块指数等。

(图片来源网络,侵删)

主要数据来源

获取数据主要有以下几种途径,各有优劣:

| 来源类型 | 优点 | 缺点 | 适用场景 |

|---|---|---|---|

| 券商/交易软件API | 数据最准、最实时、最全,官方支持,稳定可靠 | 通常需要开通证券账户,可能有使用限制或费用 | 专业量化交易、机构投资者 |

| 第三方数据服务商 | 接口标准化,数据质量高,通常提供历史数据回溯 | 需要付费,价格不菲 | 对数据质量和稳定性要求高的专业用户 |

| 免费公开API | 免费,易于获取 | 数据可能不完整、有延迟、不稳定,接口可能随时失效 | 个人学习、研究、小规模项目 |

| 网页爬虫 | 数据来源广,免费 | 反爬虫机制强,法律风险高,维护成本高,数据解析复杂 | 网站没有API时的备选方案 |

| 本地软件/文件 | 数据在本地,获取速度快 | 需要软件在后台运行,数据格式可能不标准 | 特定软件的离线分析 |

对于大多数个人开发者和小型团队,免费公开API是最佳的起点。

技术实现方法

使用免费公开 API (推荐入门)

这是最简单、最合规的方式,许多金融数据网站提供了免费的API接口。

示例:使用 akshare 库 (Python)

(图片来源网络,侵删)

akshare 是一个非常强大的、免费的金融数据接口库,它封装了众多网站的数据接口,使用起来非常方便。

安装 akshare

pip install akshare

获取实时行情数据

import akshare as ak

# 获取A股实时行情数据

# 返回一个包含所有A股实时行情的DataFrame

stock_zh_a_spot_df = ak.stock_zh_a_spot_em()

# 查看前5行数据

print(stock_zh_a_spot_df.head())

# 获取特定股票的实时行情,'000001' (平安银行)

stock_code = "000001"

stock_info = ak.stock_zh_a_spot_em()[ak.stock_zh_a_spot_em['代码'] == stock_code]

print(f"\n{stock_code} 的实时行情:")

print(stock_info)

# 获取实时五档行情

stock_code = "000001"

stock_order_queue = ak.stock_zh_a_spot_em()

# 注意:akshare的五档行情接口可能需要特定股票代码格式

# 这里以东方财富为例

stock_order_queue_detail = ak.stock_zh_a_spot_em()

print(f"\n{stock_code} 的五档行情示例 (需要指定接口):")

# ak.stock_zh_a_spot_em() 返回的是综合行情,五档行情有专门的接口

# ak.stock_zh_a_spot_em() 已经包含了买一卖一等信息

获取历史K线数据

# 获取 '000001' (平安银行) 的日线数据,最近100天

stock_code = "000001"

start_date = "20250101"

end_date = "20251231"

daily_df = ak.stock_zh_a_hist(symbol=stock_code, period="daily", start_date=start_date, end_date=end_date, adjust="qfq")

print(f"\n{stock_code} 的日线历史数据:")

print(daily_df.head())

优点:

- 免费,开箱即用。

- 接口稳定,维护者持续更新。

- 避免了编写复杂爬虫的麻烦。

缺点:

- 数据来源非官方,可能有微小延迟。

- 调用频率过高可能被临时封禁IP。

使用券商/交易软件的API (专业级)

这是专业量化交易的主流方式,国内主流券商如华泰证券、国泰君安、中信证券等都提供了程序化交易接口。

以华泰证券的 xtp 接口为例:

- 开户:必须是在该券商开户的真实证券账户。

- 申请权限:向券商申请使用程序化交易接口的权限。

- 获取SDK:下载官方提供的SDK(通常为C++/Java/Python版本)。

- 接入行情服务器:使用SDK连接券商的行情服务器,订阅你关心的股票代码。

Python 示例概念 (需先安装xtp库):

# 这只是一个概念性示例,实际使用需要券商的授权和SDK # import xtp # 假设已安装 # 初始化行情API # api = xtp.XTPAPI() # api.login(account, password, server_ip, server_port) # 订阅股票行情 # api.subscribe_stock(['000001.SZ', '600000.SH']) # 订阅平安银行和浦发银行 # 启动行情接收循环 # 在一个循环中,通过回调函数接收实时数据 # while True: # market_data = api.get_market_data() # if market_data: # print(market_data) # 处理数据 # api.logout()

优点:

- 速度最快,直连交易所或券商服务器,延迟极低。

- 数据最权威,官方源头,无延迟。

- 功能最全,除了行情,还能进行交易。

缺点:

- 门槛高,需要真实账户和权限。

- 有费用,部分券商会收取使用费。

- 技术实现复杂,需要学习特定API。

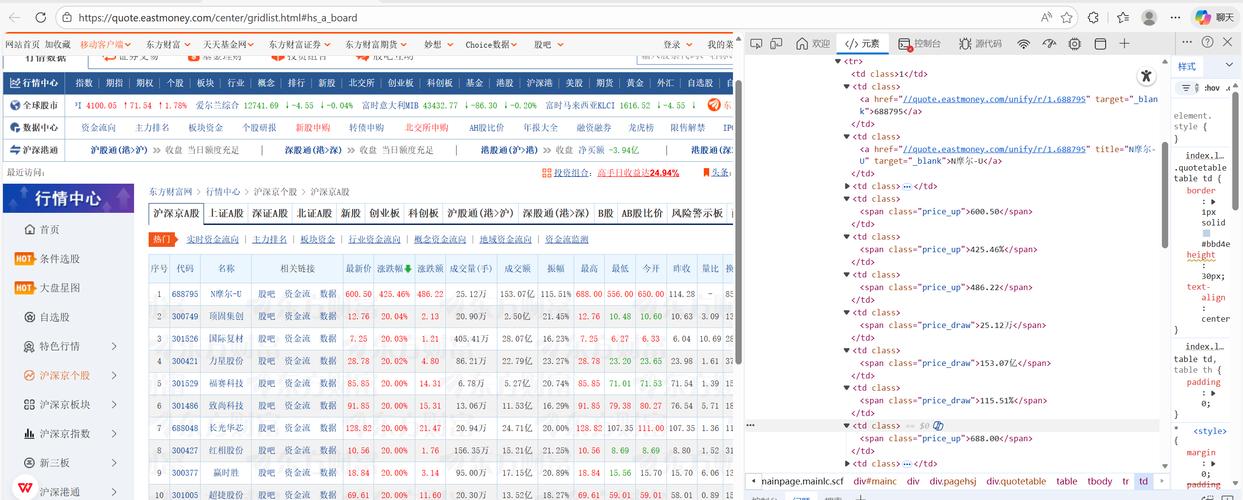

编写网页爬虫 (备用方案)

当API不可用或无法满足需求时,可以考虑爬虫,但请务必遵守目标网站的robots.txt协议,并不要进行高频请求,以免对服务器造成负担。

示例:使用 requests 和 BeautifulSoup (Python)

假设我们要爬取某个网站上的股票列表。

安装库

pip install requests beautifulsoup4 pandas

爬取示例

import requests

from bs4 import BeautifulSoup

import pandas as pd

# 目标URL (仅为示例,实际网站结构不同)

url = "http://quote.eastmoney.com/center/boardlist.html#B-BK04"

# 设置请求头,模拟浏览器访问

headers = {

'User-Agent': 'Mozilla/5.0 (Windows NT 10.0; Win64; x64) AppleWebKit/537.36 (KHTML, like Gecko) Chrome/91.0.4472.124 Safari/537.36'

}

try:

response = requests.get(url, headers=headers)

response.raise_for_status() # 如果请求失败则抛出异常

soup = BeautifulSoup(response.text, 'html.parser')

# 使用开发者工具找到数据所在的表格

# 这里的选择器是示例,需要根据实际网页HTML结构调整

table = soup.find('table', {'class': 'board-list'})

if table:

rows = table.find_all('tr')[1:] # 跳过表头

data = []

for row in rows:

cols = row.find_all('td')

if len(cols) > 0:

code = cols[0].text.strip()

name = cols[1].text.strip()

data.append([code, name])

df = pd.DataFrame(data, columns=['代码', '名称'])

print(df.head())

else:

print("未找到目标表格,请检查网页结构是否已改变。")

except requests.exceptions.RequestException as e:

print(f"请求失败: {e}")

优点:

- 灵活性高,可以获取任何网页上的公开数据。

- 免费。

缺点:

- 反爬虫风险:网站可能会封禁你的IP。

- 维护成本高:网站一旦改版,爬虫代码就可能失效,需要重新编写。

- 法律风险:需确保爬取行为不违反法律法规和网站服务条款。

数据存储与管理

采集到的数据需要妥善存储,以便后续分析。

-

CSV/Excel 文件

- 优点:简单、直观,适合小规模数据和手动查看。

- 缺点:不适合高频数据写入,数据量大时性能差。

-

关系型数据库

- 推荐:SQLite (轻量级,无需服务器) 或 MySQL/PostgreSQL (功能更强大)。

- 优点:结构化存储,支持复杂查询,数据一致性好。

- 缺点:需要一定的数据库知识。

-

时序数据库

- 强烈推荐:InfluxDB 或 TimescaleDB (PostgreSQL的扩展)。

- 优点:为处理时间序列数据而优化,写入和查询速度极快,数据压缩率高。

- 缺点:需要学习新的数据库概念。

数据存储最佳实践:

- 分表/分库:按股票代码或数据类型分开存储,避免单表过大。

- 索引优化:为常用查询字段(如股票代码、时间戳)建立索引。

- 数据清洗:在入库前对数据进行清洗,处理缺失值、异常值。

重要注意事项与合规性

- 遵守法律法规:进行证券相关的数据采集和处理,需要遵守《网络安全法》、《数据安全法》等相关法律法规,未经授权,不得抓取非公开数据。

- 尊重

robots.txt:在爬取任何网站前,务必先检查其robots.txt文件(http://example.com/robots.txt),了解网站的爬取规则。 - 控制请求频率:高频请求会给对方服务器带来巨大压力,也容易被识别为爬虫,在代码中加入

time.sleep()来控制请求间隔。 - 数据准确性:免费API的数据可能存在延迟或错误,对于交易等高风险应用,务必以券商官方数据为准。

- 数据备份:行情数据非常宝贵,一定要做好定期备份,防止数据丢失。

总结建议

- 如果你是初学者或个人爱好者:从

akshare这样的免费API库开始,它是最简单、最高效的入门方式。 - 如果你是专业量化交易者或机构:务必申请使用 券商官方API,这是速度和稳定性的保障。

- 如果API无法满足特定需求:再考虑编写 网页爬虫,但要时刻注意合规性和网站的反爬策略。

- 无论哪种方式:都要重视 数据存储,对于长期项目,使用 时序数据库 是最佳选择。

文章版权及转载声明

作者:咔咔本文地址:https://www.jits.cn/content/24015.html发布于 前天

文章转载或复制请以超链接形式并注明出处杰思科技・AI 股讯

还没有评论,来说两句吧...